Les algorithmes ne sont pas une fatalité

Les algorithmes façonnent silencieusement notre quotidien. Ils hiérarchisent l’information que nous consultons, influencent nos choix culturels, orientent nos comportements de consommation et structurent de plus en plus nos environnements professionnels. Cette influence diffuse nourrit des inquiétudes légitimes. Mais pour en débattre lucidement, encore faut-il revenir à une compréhension rigoureuse de ce que sont réellement les algorithmes, et surtout de ce qu’ils ne sont pas.

Une logique économique structurante, mais assumée

Dans l’immense majorité des cas, la conception d’un algorithme obéit à une logique claire : créer un avantage économique mesurable.

Il peut s’agir de capter davantage de temps d’attention afin de le transformer en revenus publicitaires, d’optimiser des processus pour accroître la productivité, de réaliser des économies d’échelle par l’automatisation, ou encore d’aller plus vite, en réduisant les délais et les coûts.

Cette logique n’a rien d’exceptionnel. Elle s’inscrit dans une continuité historique : celle de la mécanisation, puis de l’informatisation, et aujourd’hui de l’automatisation algorithmique. Les algorithmes ne sont pas des anomalies du capitalisme numérique ; ils en sont une expression contemporaine.

Il n’y a donc rien à « regretter » en tant que tel. Les algorithmes sont construits sur des modèles de rentabilité, comme de nombreux outils techniques avant eux. Le véritable enjeu n’est pas leur existence, mais la place qu’on leur accorde et les critères que l’on choisit de privilégier.

Des systèmes de choix, composés d’ingrédients

Un algorithme n’est ni neutre ni autonome. Il est le résultat d’une série de décisions humaines : quelles données prendre en compte, quels critères prioriser, quels objectifs maximiser, quels effets considérer comme acceptables.

À ce titre, un algorithme ressemble davantage à une recette qu’à une force abstraite. Il est composé d’ingrédients : popularité, rapidité, engagement, répétition, coût, prédictibilité. Selon le dosage retenu, le résultat final change radicalement.

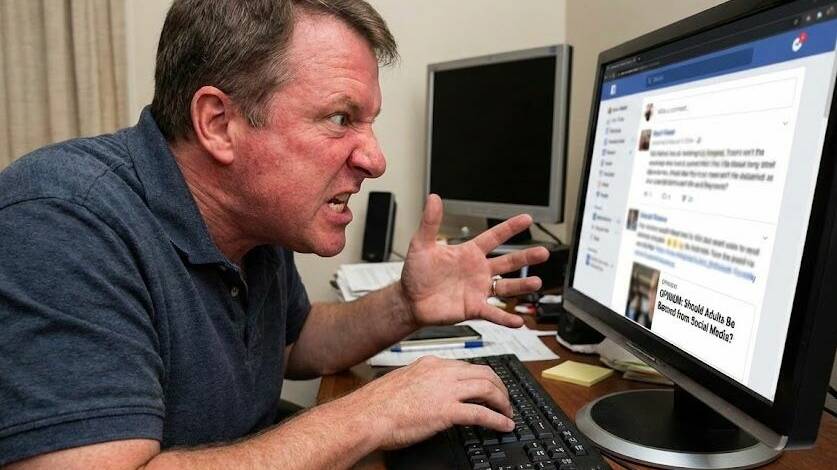

Comme en cuisine ou en pharmacologie, tous les ingrédients ne se valent pas. Certains sont bénéfiques dans un contexte précis et problématiques dans un autre. D’autres, lorsqu’ils sont mal dosés ou appliqués à grande échelle, peuvent produire des effets secondaires lourds : enfermement informationnel, polarisation des opinions, standardisation des comportements, amplification des émotions extrêmes.

Un algorithme ne fait jamais que ce pour quoi il a été conçu. Il amplifie mécaniquement les priorités qu’on lui a assignées.

L’angle mort persistant de la transparence

Nos sociétés ont progressivement intégré une idée essentielle : lorsqu’un produit a un impact sur notre santé ou notre bien-être, nous avons le droit d’en connaître la composition.

Nous lisons les étiquettes alimentaires, les notices de médicaments, les matériaux de nos vêtements. Cette transparence ne supprime pas le risque, mais elle permet un choix éclairé et une responsabilité partagée.

Les algorithmes, en revanche, échappent encore largement à cette exigence. Leur fonctionnement demeure souvent opaque, protégé par des secrets industriels ou résumé à des formules vagues et pédagogiquement insuffisantes. Or leur influence sur nos représentations du monde, nos décisions et parfois nos équilibres démocratiques est considérable.

Cette opacité crée un déséquilibre fondamental : nous sommes exposés à des systèmes puissants sans disposer des moyens réels de les comprendre.

Mesurer pour rendre lisible

La transparence ne peut être purement déclarative. Elle suppose des outils de mesure et de lisibilité, capables de rendre intelligibles des mécanismes complexes sans les simplifier à l’excès. À l’image de ce que représente l’« infowatt », développé par Marc Ansoult, pour rendre mesurable la puissance d’une information dans le monde numérique. Un indicateur bien utils pour objectiver l’impact d’un algorithme.

Rendre lisible un algorithme, ce n’est pas en dévoiler chaque ligne de code, mais permettre d’en comprendre les effets mesurables : sur l’attention, sur la diversité des contenus, sur les comportements induits. Des outils standardisés, accessibles et comparables offriraient aux citoyens, aux chercheurs et aux décideurs une base commune de compréhension. Sans mesure, il n’y a ni débat éclairé ni régulation efficace.

Comprendre pour classer, réguler et paramétrer

Cette lisibilité ouvrirait la voie à une approche plus mature de la régulation. Tous les algorithmes n’ont pas la même finalité ni le même impact. Un système qui optimise un trajet urbain n’a pas les mêmes conséquences qu’un algorithme qui hiérarchise l’information politique ou influence des décisions collectives.

Comprendre les ingrédients et les effets permettrait de classer les algorithmes selon leur niveau de risque, d’encadrer certains usages, d’en limiter les effets indésirables, voire d’en interdire certains dans des contextes précis. À défaut d’interdiction, il deviendrait possible d’en paramétrer l’usage, en connaissance de cause.

Vers une gouvernance internationale des algorithmes

Face à des systèmes globaux, déployés à l’échelle planétaire, la réponse ne peut être uniquement nationale ou fragmentée. Il devient urgent de penser la création d’une agence internationale de l’algorithme, indépendante, dotée de compétences techniques, éthiques et juridiques.

Une telle instance aurait pour mission de lire, comprendre, auditer et, le cas échéant, dénoncer les algorithmes présentant un impact négatif avéré sur la société. À l’image des agences sanitaires ou environnementales, elle ne déciderait pas à la place des citoyens, mais fournirait une expertise fiable, publique et contradictoire. Sans contre-pouvoir structuré, la complexité algorithmique reste un angle mort démocratique.

Replacer la technique à sa juste place

Le débat sur les algorithmes n’est pas un débat technophobe. Il est profondément politique et culturel. Il interroge notre rapport à l’optimisation permanente, à la vitesse, à la rentabilité érigée en horizon indiscutable.

Les algorithmes doivent rester des moyens au service des humains, et non des cadres invisibles auxquels nous nous adaptons passivement. Reprendre le contrôle ne signifie pas rejeter la technologie, mais lui redonner une place subordonnée au discernement humain, à la pluralité des valeurs et au temps long.

Les algorithmes sont conçus par des humains, pour des humains.

Pour cette raison même, ils ne sont pas une fatalité.